Международный коллектив учёных Института искусственного интеллекта AIRI,

Сколтеха, МИФИ, Нью-Йоркского университета и Технического университета

Мюнхена представил крупномасштабный мультисенсорный набор данных для

многоракурсной 3D-реконструкции. Учёные выложили в открытый доступ 1 390 000

изображений.

Большинство 3D-объектов — это восстановленные трёхмерные модели реальных

предметов, зданий или людей. Исследователи по всему миру активно работают над

созданием ИИ-алгоритмов, которые позволят сократить количество сложных

манипуляций с датчиками и создавать 3D-объекты прямо из фотографий.

Типы сенсорных данных для 3D-реконструкции варьируются от изображений

узкоспециализированных и дорогих компьютерных томографов или лазерных

сканеров до видео с камер мобильного телефона и датчиков глубины беспилотного

авто. Обычно, вычислительные методы трёхмерной реконструкции разрабатываются

под определённый тип данных, что ограничивает их возможности. Например, по

данным фото можно получить трёхмерную геометрию высокой точности, но

проблематично восстановить визуально однородную поверхность, такую как

одноцветная стена. Реконструкция по данным с датчиков глубины лишена этой

проблемы, но ей недостаёт точности. Стабильно получать полные и точные

реконструкции можно путём совмещения разных типов сенсорных данных с помощью

алгоритмов искусственного интеллекта.

Для упрощения разработки таких алгоритмов, для их оценки и обучения, учёные

выложили в открытый доступ новый набор данных, содержащий изображения с

различных датчиков RGB и глубины: смартфонов, Intel RealSense, Microsoft Kinect,

промышленных камер и сканера структурированного света. Исследователи

настроили контролируемое освещение и с помощью специализированной установки

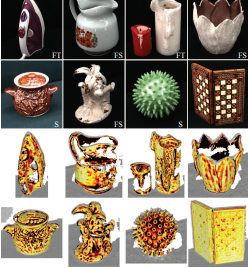

собрали 1,39 млн изображений 107 небольших объектов. Каждый объект был снят со

100 различных ракурсов на сфере радиусом 70 см вокруг него и при 14 типах

освещения. Такое количество снимков необходимо, чтобы обеспечить стабильность

обучения алгоритмов, которые смогут корректно работать с отражениями, тенями и

текстурами. Объекты выбирали так, чтобы включить в набор максимально сложные и

проблемные для существующих методов реконструкции примеры — визуально

однородные и одноцветные поверхности, а также глянцевые, зеркальные, и

полупрозрачные.

Кроме того, в ходе исследования авторы обнаружили корреляцию между свойствами

отражательной способности поверхности и качеством реконструкции, получаемой

ИИ-алгоритмом. Чем больше текстуры или непрозрачных деталей на объекте, тем

лучше окажется качество реконструкции.

«Мы ожидаем, что наш набор данных будет полезен для оценки и обучения

алгоритмов 3D-реконструкции и для связанных задач. Благодаря проделанной

работе появилась возможность выявить случаи, когда существующие алгоритмы

ИИ-реконструкции не справляются, и описать причины такого поведения

алгоритмов. Эта информация крайне ценна и уже сейчас позволяет улучшать

алгоритмы ИИ-реконструкции, чтобы в итоге разработать эффективные и

точные ИИ-системы для моделирования 3D-форм объектов в произвольных

условиях», — отмечает Евгений Бурнаев, ведущий научный сотрудник Института AIRI, профессор,

директор Центра прикладного искусственного интеллекта Сколтеха.

«Этот проект — крайне сложный не только с методологической точки зрения, но

и потому, что пришлось решить огромное число инженерных задач, связанных с

построением установки на основе робо-манипулятора, который использовался для

точного позиционирования сенсоров и автоматизации процесса получения данных.

К счастью, мы преодолели все трудности, и сейчас, за счёт приобретённого

опыта, можем такого рода работу ставить на поток. Более того, разработанная

установка может использоваться для сбора 3D-данных об объекте для

последующей очень точной реконструкции его 3D-формы», — рассказывает

Олег Войнов, научный сотрудник Института AIRI и инженер-исследователь

Центра прикладного искусственного интеллекта Сколтеха

Научная статья с описанием процесса подготовки датасета была опубликована на

конференции Computer Vision and Pattern Recognition 2023 (А*), одной из самых

значимых конференций в области компьютерного зрения. Получить доступ к датасету

можно по ссылке.

Нет комментариев